大模型:智能的新纪元

在机器学习的浩瀚宇宙中,大模型犹如璀璨的星辰,以其庞大的参数规模和复杂的计算架构,引领着智能科技的新浪潮。这些由深度神经网络精心构建的模型,拥有数十亿甚至数千亿个参数,旨在提升模型的表达力和预测精度,以应对日益复杂的任务和数据挑战。

大模型的应用领域广泛,从自然语言处理到计算机视觉,从语音识别到推荐系统,它们的身影无处不在。通过海量数据的洗礼,这些模型学会了识别复杂的模式和特征,展现出超越以往的泛化能力,能够对未知数据做出精准的预测。

ChatGPT对大模型的阐释,更是以其贴近人类思维的方式,为我们描绘了一幅智能的图景:大模型,本质上是利用海量数据精心培育的深度神经网络,其庞大的数据和参数规模,孕育了智能的涌现,仿佛赋予了机器类似人类的智能。

这种智能的涌现,不仅仅是参数数量的简单累积,而是在达到一定规模后,模型突然展现出的、之前小模型所不具备的复杂能力和特性。这种能力,让我们对机器学习的未来充满了无限的想象和期待。

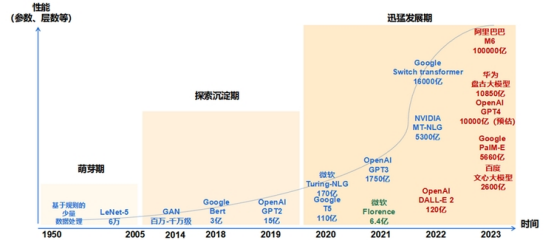

大模型的发展历程:从萌芽到迅猛发展

大模型的发展历程可以划分为三个主要阶段,每个阶段都标志着人工智能领域的重要进步。

1. 萌芽期(1950-2005)

1956年:计算机专家约翰·麦卡锡首次提出“人工智能”概念,标志着AI领域的诞生。

1980年:卷积神经网络(CNN)的雏形诞生,为后续的深度学习奠定了基础。

1998年:LeNet-5的出现,标志着机器学习从浅层模型向深度学习模型的转变,为自然语言处理和计算机视觉等领域的研究奠定了基础。

2. 探索沉淀期(2006-2019)

2013年:Word2Vec模型的诞生,首次提出将单词转换为向量的“词向量模型”,极大地推动了自然语言处理技术的发展。

2014年:对抗式生成网络(GAN)的诞生,标志着深度学习进入了生成模型研究的新阶段。

2017年:Google提出了基于自注意力机制的Transformer架构,为大模型的预训练算法架构奠定了基础。

2018年:OpenAI和Google分别发布了GPT-1与BERT,标志着预训练大模型成为自然语言处理领域的主流。

3. 迅猛发展期(2020-至今)

2020年:OpenAI推出了GPT-3,模型参数规模达到1750亿,成为当时最大的语言模型,并在零样本学习任务上实现了巨大性能提升。

2022年11月:搭载了GPT-3.5的ChatGPT发布,以其逼真的自然语言交互和多场景内容生成能力,迅速成为互联网上的热门话题。

2023年3月:GPT-4的发布,这是一个超大规模的多模态预训练大模型,具备了多模态理解与多类型内容生成能力,标志着大数据、大算力和大算法的完美结合,大幅提升了大模型的预训练和生成能力。

未来展望

大模型的发展将继续推动人工智能技术的边界,预计未来将在多模态学习、边缘计算、个性化服务等领域发挥更大作用。同时,随着技术的不断进步,大模型在处理复杂任务、提高决策效率以及促进科学发现方面的能力将进一步加强。

大模型的发展历程不仅是技术的积累,也是人类对智能本质探索的反映。随着研究的深入和技术的成熟,大模型将在更多领域展现其潜力,为社会带来深远的影响。